MongoDB - NoSQL

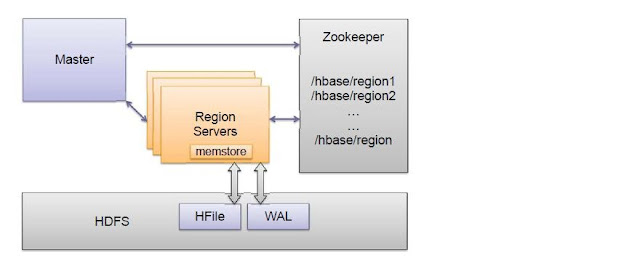

No post de 26 de agosto de 2013, falamos sobre os bancos de dados NoSQL (Not Only SQL), mais especificamente sobre o HBase, que é orientado a colunas. Além dos bancos NoSQL orientados a colunas, existem outros tipos de bancos NoSQL orientados a documentos, grafos, chave-valor, objetos, etc. Os bancos NoSQL orientados a documentos foram projetados para facilitar a armazenagem e recuperação de grandes volumes de documentos e são muito empregados em aplicações que requerem gerenciamento de grandes volumes de conteúdo digital, gerenciamento de dados de usuários, infraestrutura social e mobile, etc. O MongoDB ( www.mongodb.org ) é um dos principais bancos NoSQL orientado a documentos, existente no mercado. Como exemplo de empresas que usam o MongoDB temos a Forbes, o Foursquare, a Leroy Merlin, o CERN, etc. Com o MongoDB podemos armazenar documentos usando padrão BSON, criar índices para tornar buscas mais rápidas e gerenciar réplicas do ambiente provendo assim redu