Montando o seu ambiente Big Data

Existem

hoje no mercado diversas opções para montar um ambiente para processamento de grandes quantidades de

dados utilizando a plataforma Big Data (Hadoop, HDFS, Hive, HBASE, Pig, etc).

Uma das opções iniciais é montar seu próprio

cluster com máquinas servidoras de baixo custo existentes no mercado, fazer o download dos softwares do site da

Fundação Apache, realizar as instalações e configurações necessárias para

utilizá-lo da maneira mais rápida possível, sem pagamento de licenças ou

mensalidades de manutenção de software. Caso não tenha os recursos necessários

é possível com apenas uma máquina

configurar e testar o ambiente do Hadoop. Normalmente este é o caminho utilizado

durante o aprendizado ou por pequenas empresas,

que ainda não podem arcar com custos adicionais. Nestes casos o suporte e

resolução de problemas é feito por buscas na internet, buscas em comunidades ou com o auxílio

de profissionais com experiência nestes ambientes.

Existem também grandes

empresas que mantém diversos datacenters e diversos times especializados, tanto

de infraestrutura como de desenvolvimento e suporte e que utilizam o software da

Fundação Apache, sem modificações ou adaptado com suas próprias versões dos

pacotes.

Como alternativa ao Hadoop obtido

diretamente por download do site da Apache, que não possui estrutura de

suporte profissional especializado, existem no mercado algumas distribuições, dentre as quais gostaria de destacar a distribuição da Pivotal (http://www.gopivotal.com/), a da Hortonworks (http://hortonworks.com/) e a da Cloudera (www.cloudera.com).

A

distribuição Pivotal HD Enterprise é uma distribuição comercial do Apache

Hadoop que inclui o HDFS, MapReduce,

Hive, Mahout, Pig, HBase, Yarn, Zookeeper, Sqoop e Flume da Fundação Apache,

suportados por uma das maiores organizações de suporte Hadoop e testados em

larga scala com mais de 1000 nós utilizando também o Pivotal Analytics

Workbench. É 100% baseada na plataforma Hadoop, possui um engenho de SQL

próprio para o Hadoop, está disponível como solução baseada em appliances e

conta com a infraestrutura de suporte global 24X7 da

EMC. O engenho de banco de dados SQL

ANSI da Pivotal é o HAWQ. Com este

engenho de BD a empresa pode rapidamente utilizar uma nova plataforma voltada

para processamento de grandes volumes de dados e reutilizar todo o conhecimento

de SQL que seus profissionais tem acumulado ao longo dos anos, não sendo

necessário aprender novas linguagens de imediato, tornado assim a curva de aprendizado mais suave.

O

Hortonworks é uma distribuição do Hadoop que também tem suporte pago, próprio

para companhias que pretendem utilizar a plataforma Hadoop, mas não podem

prescindir de um suporte especializado.

O Hortonworks, além de executar em sistema operacional Linux, executa também em Servidores Windows,

diferentemente da distribuição da Apache, que não é própria para executar em

Windows. No ambiente Windows a

distribuição da Apache deve ser executada usando o Cygwin, que é um software

que emula o Unix no Windows.

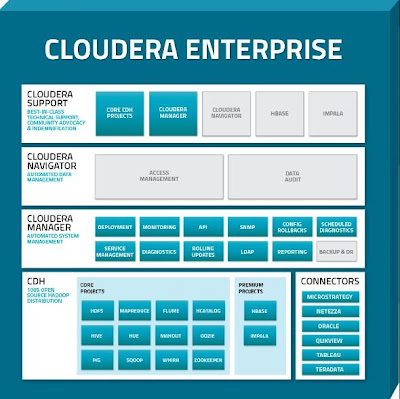

Outra

distribuição existente no mercado é a Cloudera, que oferece software, serviços

e suporte em 3 formatos. O Cloudera

Enterprise, que inclui o Cloudera Distribution Hadoop (CDH), uma subscrição

anual por nós utilizados do Cloudera Manager Enterprise e suporte técnico. Já o pacote Cloudera Enterprise Free, inclui

o CDH e uma versão mais simples do Cloudera Manager. Existe também uma versão free sem suporte. O

Cloudera Manager permite fazer o deployment rápido de novos nós, gerenciar e

monitorar a performance do cluster CDH. As funções mais avançadas do Cloudera

Manager , estão presentes apenas na versão Enterprise. Em Outubro de 2012 a Cloudera lançou o Impala, que é um

engenho de queries MPP, que roda sob o Hadoop.

O projeto Impala traz a tecnologia de banco de dados para o Hadoop,

permitindo execução de queries com baixa latência para dados ar,azenados no

HDFS e no HBASE, uso de SQL, integração com ferramentas de BI e

Analíticos( Tableau, Microstrategy, QlikView,

Pentaho, etc).

Espero que este post possa auxiliar na sua escolha inicial e caso tenha dúvidas por favor entre em contato. Até o próximo post.

Comentários

Postar um comentário